Wydobycie kryptowalut coraz mniej się opłaca. Po halvingu Bitcoina mniej wydajni górnicy muszą nawet dokładać do interesu! Tymczasem nasze GPU wciąż może zapewnić nam dochód, pracując na rzecz platform sztucznej inteligencji. Czas na mining AI.

Mining AI, czyli ewolucja kopania

Mining AI to nowy sposób wykorzystania mocy obliczeniowej, któray wyewoluował z tradycyjnego wydobycia krypto. W przeciwieństwie do klasycznego kopania i rozwiązywania problemów kryptograficznych, ten nowy rodzaj miningu pozwala dokonywać obliczeń związanych z AI i uczeniem maszynowym.

Zasada jest prosta. Właściciele sprzętu udostępniają swoje zasoby, a klienci – firmy AI i startupy technologiczne – wynajmują je do trenowania swoich modeli, analizy danych czy renderowania grafiki.

Rynek ten rozwija się szybko. Sprzyja temu gwałtowny rozwój branży sztucznej inteligencji oraz postęp w technologii GPU, pozwalający na efektywne wykorzystanie kart graficznych.

Taki mining to żadna ściema. Nawet CERN wykorzystuje GPU do analizy danych z eksperymentów w Wielkim Zderzaczu Hadronów.

Możliwe zastosowania GPU

Popyt na moc obliczeniową ma kilka źródeł. Przetwarzania ogromnych ilości danych wymaga np. uczenie sieci neuronowych typu GPT Chat. Podczas uczenia maszynowego (ML), niezbędna jest klasyfikacja i łączenie danych. W takich zastosowaniach, np. trenowaniu algorytmów rozpoznawania obrazów, GPU są nawet 20-40 razy szybsze od CPU.

Innym źródłem popytu na takie usługi jest sektor BigData. Wymaga on analizowania ogromnych zbiorów danych w czasie rzeczywistym. W branży finansowej będzie to np. badanie setek tysięcy transakcji na sekundę w celu wykrycia oszustw.

Inne zastosowania obejmują renderowanie grafiki 3D, gdzie GPU znacząco przyspieszają proces tworzenia fotorealistycznych obrazów. MidJourney czy DALL-E wykorzystują tysiące kart graficznych, aby błyskawicznie dostarczać żądane ilustracje.

Firma Anthropic wykorzystuje moc obliczeniową do treningu swojego modelu językowego Claude. JPMorgan Chase używa jej do analizy ryzyka i optymalizacji portfela. Pixar, wykorzystuje farmy GPU do renderowania swoich animacji. Firma biotechnologiczna Atomwise przyspiesza dzięki nim proces odkrywania nowych leków. Przetwarzanie danych jest potrzebne wszędzie.

Dlaczego nie ASIC?

Jak wiemy, koparki ASIC w dużym stopniu zdominowały proces kopania kryptowalut. Dlaczego nie są zatem na dużą skalę wykorzystywane w branży AI i ML?

Choć ASIC są bardzo wydajne w wykonywaniu jednego konkretnego zadania, GPU charakteryzują się duża większą elastycznością i mogą być one wykorzystywane w bardzo wielu zastosowaniach.

Ta wszechstronność bardzo cenna w środowisku, gdzie algorytmy i modele AI błyskawicznie ewoluują. GPU można łatwo przystosować do nowych zadań, podczas gdy ASIC wymagałyby całkowitego przeprojektowania sprzętu.

Karty graficzne są ponadto produkowane masowo, co czyni je tańszymi i łatwiejszymi do zdobycia. Dodatkowo systemy GPU można łatwo skalować, dodając lub wymieniając karty w zależności od potrzeb.

GPU oferują również lepszą wydajność energetyczną. Choć ASIC mogą być oszczędne w wybranych zastosowaniach, to branży sztucznej inteligencji karty graficzne okazują się bardziej opłacalne.

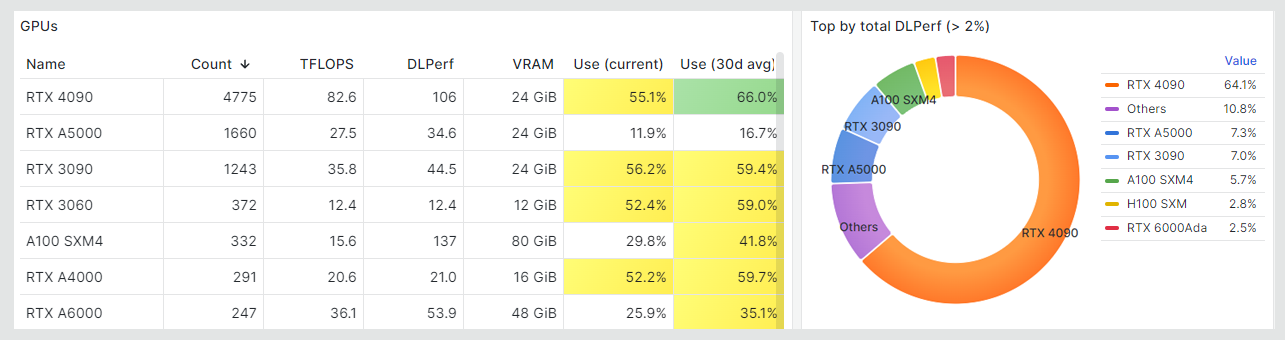

Nvidia i jej konkurencja

Dominującą rolę w ekosystemie AI odgrywa Nvidia, głównie dzięki standardowi CUDA i bardzo wydajnym GPU. Karty graficzne serii GeForce RTX 4090 oferują imponującą wydajność 82 TFLOPS, co czyni je użytecznymi w rozwiązywaniu problemów AI. Profesjonalne układy, takie jak A100 i H100, stanowią trzon infrastruktury w dużych centrach danych.

Konkurencja stara się dorównać liderowi. AMD promuje swoją serię MI300X. Również Intel czy Apple rozwijają swoje układy, odpowiednio Ponte Vecchio i Apple Silicon. Swoje specyficzne projekty, zbliżone do ASIC, buduje także Google.

Opłacalność czyli zyski kontra koszty

Po wstępie teoretycznym czas na konkrety. Czy na kopaniu za pomocą AI da się zarobić?

Jak zawsze zależy to od wielu czynników, głównie kosztów sprzętu, energii elektrycznej oraz źródła przychodów. Rozbijmy to na czynniki pierwsze.

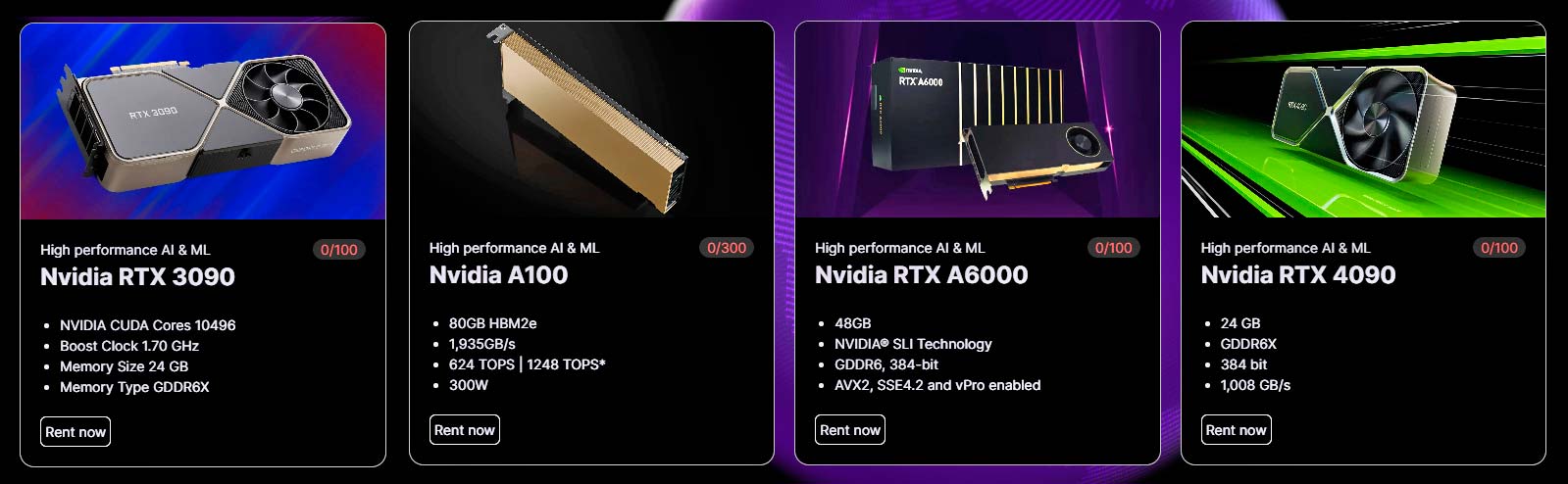

- Koszty sprzętu stanowią inwestycję początkową. Karta NVIDIA GeForce RTX 4090, wydajna i lubiana w miningu AI, kosztuje około 8-9 tysięcy złotych. Profesjonalne układy, takie jak NVIDIA A100 to już koszt kilkudziesięciu tysięcy złotych. Ceny H100 pomińmy milczeniem. 😉 Skoncentrujemy się zatem na GeForce RTX 4090 lub tańszym modelu GeForce RTX 4080 (4-5 tyś. zł) Oczywiście do tego musimy dołożyć również komputer.

- Koszt energii to koszmar, jak pisaliśmy już w artykule o kopaniu kryptowalut na komputerze. Jeśli pominiemy obowiązujące do końca 2024 r. programy osłonowe, jej cena zaczyna się od 1 zł/kWh i ma tendencję rosnącą.

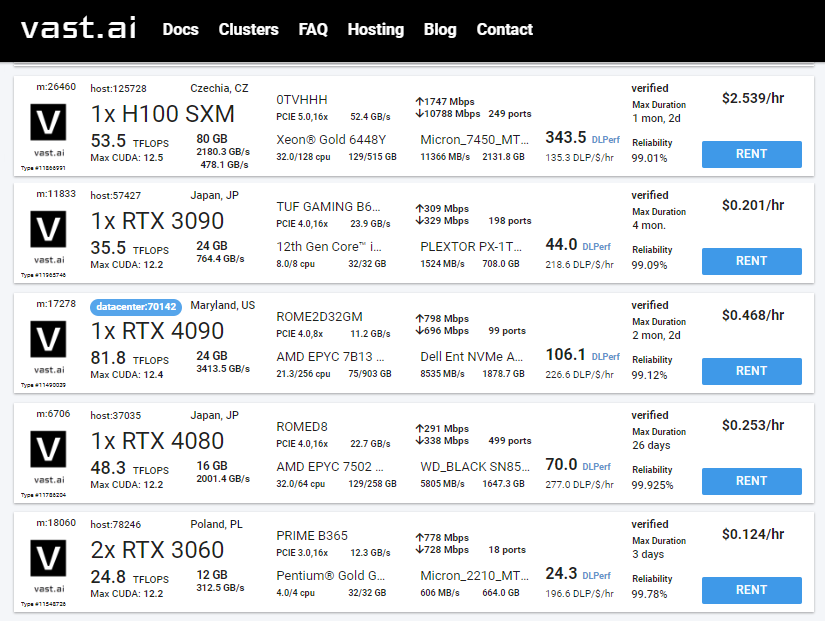

- Potencjalne przychody zależą od popytu na moc obliczeniową i stawek oferowanych przez platformy wynajmu GPU. Popularny serwis Vast.ai w sierpniu 2024 oferuje właścicielom GeForce RTX 4090 ok. 40 centów za godzinę pracy, RTX 4080 połowę z tego.

W przeciwieństwie do kopania kryptowalut, GPU nie pracuje stale, ale wtedy, kiedy jest zapotrzebowanie. Zweryfikowani, wiarygodni użytkownicy mogą liczyć na obłożenie przez 60-80% czasu udostępniania kart.

Kopanie AI: liczymy zarobki

Na początek sprawdźmy nasze zyski w sytuacji optymalnej – komputer już mamy, RTX 4090 też, podobnie jak wydajne łącze internetowe. O prąd nie musimy się martwić, gdyż dostarczają go solary na dachu. Za to jesteśmy początkujący i nie mamy renomy solidnego dostawcy, zatem nasz sprzęt pracuje tylko 12 godzin dziennie.

Zarobek dzienny możemy zatem założyć jako: 0,4 $ x12 = 4,8 $. Niestety często 20-25% z tego musimy oddać firmie pośredniczącej jako opłatę za jej usługi.

Mining AI pozwala zatem na dzienny zarobek około 4 dolarów, co przekłada się na 120 $ miesięcznie.

Całkiem nieźle! Nawet jeśli kartę musieliśmy kupić za 1800$ a nie dostaliśmy w prezencie, zwróci nam się ona po półtorej roku. Jeśli z czasem zostaniemy wiarygodnym dostawcą z długą praktyką, dobowy czas pracy powinien wydłużyć się z 12 do powiedzmy 16-18 godzin.

Są jednak co najmniej dwa haczyki.

- GPU zużywa się podczas pracy. Nawet jeśli będziemy dbać o chłodzenie, raczej nie posłuży nam dłużej niż 3-4 lata

- za rok zapewne wejdą nowe modele GPU, więc stawki oferowane za 4090 nieco spadną

Jeśli musimy płacić za prąd, kalkulacja zmienia się diametralnie. Sam RTX 4090 potrzebuje 450 W, moc całego zestawu określmy więc skromnie na 600 W. Przy założeniu, że tylko 12 godzin sprzęt pracuje aktywnie, a przez pozostały oczekuje na zlecenia, dobowe zużycie energii wyniesie pi razy oko 8 kWh.

Zakładając średnią cenę 1,1 zł/kWh, miesięczny koszt energii zużytej przez nasz system wyniesie około 260 zł. Co jakiś czas będziemy musieli też dokonać konserwacji, przedmuchać wentylatory, zmienić pastę na procesorze… Zaokrąglijmy więc koszty do 300 zł – przy założeniu, że żadna część nie ulegnie awarii.

W tej sytuacji nasz przychód 120 $ przy kursie 4 zł USD/PLN wynosi 480 zł, koszty 300 zł, na czysto zostaje nam więc 180 zł. Na nową kartę będziemy musieli zatem pracować prawie 4 lata.

Jak zawsze przy wykorzystaniu energochłonnego sprzętu wszystko rozbija się więc o to, czy mamy dostęp do darmowej energii.

Przegląd dostępnych platform

Gdzie zacząć poszukiwania, jeśli chcemy spróbować zarobić na naszym sprzęcie? Poniżej przegląd wybranych platform, działających i faktycznie zapewniających zarobki. Nie podajemy ich wysokości, ta bowiem zależna jest od bieżącego zapotrzebowania, a czasem wartości kryptowaluty, używanej w rozliczeniach.

- Vast.ai. Jedna z najbardziej znanych marek w branży. Użytkownicy mogą proponować ceny swoich GPU w zależności od aktualnego popytu. Wiele możliwości, od trenowania modeli AI po analizę danych genetycznych. Punkt odniesienia dla wielu innych platform.

- BitTensor (TAO). Znana platforma, łącząca uczenie maszynowe i rozproszone przetwarzanie danych. Łączy 36 subnetów, pozyskujących dostawców GPU do określonych zadań. Wiarygodna i wydajna, jednak konkurencja między górnikami jest bardzo silna. Niełatwo dostać się na listę dostawców. Opis projektu BitTensor .

- Clore.ai (CLORE). Relatywnie niewielka platforma, mająca jednak zaawansowany systemem optymalizacji GPU. Oferuje wybór między stałym wynagrodzeniem, a modelem opartym na wydajności. Nawiązała partnerstwa z wiodącymi instytucjami jak MIT i Uniwersytet Stanford. Użytkownicy ją lubią, choć zarobki póki co są niewielkie.

- Golem (GLM). Założony w 2016 roku, ewoluował z pierwotnego konceptu “światowego superkomputera” do ekosystemu mikrousług. Zarobki są niewysokie, ale stabilne, zaś opinie użytkowników pozytywne. Niestety, zleceń nie ma zbyt wiele.

- iExec (RLC). Obsługuje głównie firmy AI i big data. Wykorzystuje Intel SGX do zapewnienia poufności obliczeń, co czyni ją atrakcyjną dla korporacji. Przejrzysty system wypłat, ale także okresowe problemy techniczne i długi czas oczekiwania na transakcje.

- DeepBrain Chain (DBC). Wykorzystuje własny blockchain oparty na konsensusie Proof of Importance, który nagradza użytkowników nie tylko za udostępnianie zasobów, ale także za aktywność i jakość dostarczanych usług. Użytkownicy krytykują niską płynność wypłacanego jako nagroda tokena DBC.

- Render Network (RNDR). Skupia się na wsparciu renderowania 3D. Do rozliczeń używa tokena RNDR. Użytkownicy oceniają platformę pozytywnie, rentowność wydajnych GPU jest wysoka. Trudno zostać dostawcą z powodu braku miejsc. Opis projektu Render Network.

- Akash Network (AKT). Koncentruje się na dostarczaniu kompletnych środowisk wirtualnych, a nie tylko surowej mocy obliczeniowej. Dostawcy GPU konkurują o zlecenia, co prowadzi do optymalizacji cen. Użytkownicy go lubią, ale narzekają na wysoką barierę wejścia.

- IO.net (IO). Zdecentralizowana platforma obliczeniowa, wsławiona airdropem o wartości 50 milionów dolarów dla użytkowników. Ma kilku znanych klientów, jak Krea czy Nibiru. Póki co nie oferuje dużych zarobków, użytkownicy są jednak zadowoleni ze zrzutu.

- GamerHash. Połączenie platformy zarobkowej i sklepu z grami. Użytkownicy mogą wykorzystać swoje GPU, a zarobione środki wydać w sklepie platformy. GamerHash cieszy się popularnością, choć strona często wyrzuca błędy podczas wczytywania.

Istnieje także wiele innych platform, jak Theta, Cudos, Grass czy OctaSpace, jednak ich eksplorację pozostawiamy zainteresowanym czytelnikom.

Przyszłość miningu AI

Jest ona ściśle związana z rozwojem technologii uczenia maszynowego. Analizując trendy, możemy dostrzec kilka ciekawych kierunków rozwoju branży.

Jest to np. Neuromorphic Computing, czyli systemy obliczeniowe inspirowane strukturą i funkcjonowaniem ludzkiego mózgu. Technologia obiecuje ogromną wydajność, niestety wymaga zmiany tradycyjnych GPU na wyspecjalizowane chipy typu neuromorphic.

Innym trendem jest Edge AI, czyli przetwarzanie AI na urządzeniach końcowych zamiast w chmurze. Apple Neural Engine w iPhone z oczywistych przyczyn nie potrzebuje zewnętrznych GPU.

AI-as-a-Service (AIaaS) to kolejna zmiana, która może sporo namieszać. Polega na oferowaniu kompleksowych rozwiązań AI, a nie tylko mocy obliczeniowej. Przykładem może być IBM Watson, oferujący kompletne rozwiązania dla różnych branż. W tym modelu dostawcy “surowej” mocy obliczeniowej stają się mniej potrzebni.

Obliczenia analogowe to również ciekawy kierunek rozwoju. Integrują one pamięć z jednostkami obliczeniowymi, co eliminuje potrzebę przesyłania danych pomiędzy komponentami. Co więcej, dane nie muszą być przekształcane w postać binarną, co pozwala na ich szybsze przetwarzanie.

Ciekawostką są systemy oparte na świetle, wykorzystująca fotony zamiast elektronów. Startup Lightmatter już dziś tworzy fotonic chips, które mogą być 100x szybsze niż tradycyjne GPU. Podobną rewolucją może być biocomputing, wykorzystujący systemy biologiczne do wykonywania obliczeń.

O przyszłości miningu AI wiemy więc tylko tyle, że nadejdzie. O ile zatem sensowne wydaje się wykorzystanie już posiadanych zasobów, to pomysł zastawienia domu i kupno dziesiątek wypasionych GPU nie wydaje się rozsądny. Takie inwestycje zostawmy specjalistom, sami zadowalając się zarobieniem 100 dolarów miesięcznie, jeśli mamy okazję.